Trong những năm gần đây, các mô hình ngôn ngữ tự nhiên đã có bước phát triển vượt bậc, không chỉ trong khả năng xử lý văn bản mà còn trong việc áp dụng vào các lĩnh vực thực tế như chăm sóc khách hàng, tạo nội dung và nghiên cứu. Trong bài viết này, Cốc Cốc sẽ đi sâu vào việc so sánh Llama 3 và GPT-4, đánh giá những điểm mạnh, điểm yếu của từng mô hình, cũng như ứng dụng thực tế của chúng trong các lĩnh vực khác nhau.

Nội dung chính

Llama 3 là gì?

Llama 3 là một mô hình AI chuyên tạo văn bản. Giống như GPT của OpenAI hay Claude của Anthropic, bạn chỉ cần nhập một đoạn gợi ý (prompt) và mô hình sẽ sinh ra câu trả lời tương ứng. Các phiên bản mới gần đây được đánh giá cao nhờ khả năng hiểu ngữ cảnh tốt hơn và tư duy logic chính xác hơn.

Hiện nay, dòng mô hình Llama đang được Meta ứng dụng để phát triển Meta AI – trợ lý ảo thông minh đã tích hợp vào Instagram, WhatsApp, Messenger và Facebook.

Điểm đặc biệt của Llama 3 là thuộc dạng “open weights” (công khai trọng số). Điều này cho phép cộng đồng tiếp cận và nghiên cứu cách thức hoạt động của mô hình với mức độ minh bạch nhất định. Tuy vậy, những yếu tố quan trọng để tái tạo toàn bộ mô hình, chẳng hạn như bộ dữ liệu huấn luyện, vẫn chưa được Meta công bố đầy đủ.

Điểm mới của Llama 3

Meta giới thiệu Llama 3 với hai phiên bản chính: 8 tỷ tham số và 70 tỷ tham số. Như thường lệ, số tham số càng nhiều thì khả năng sinh văn bản càng chính xác, nhưng đổi lại tốc độ xử lý sẽ chậm hơn và chi phí vận hành cao hơn. Phiên bản 70B được xem là ngang tầm với nhiều đối thủ trên thị trường, trong khi Meta cũng tiết lộ họ đang phát triển một mô hình khổng lồ 400B tham số.

Một cải tiến quan trọng khác là cửa sổ ngữ cảnh tăng từ 4.096 lên 8.192 token. Với cách tính trung bình, mô hình giờ có thể xử lý tương đương khoảng 15 trang văn bản tiếng Anh cùng lúc. Đây là bước tiến đáng kể, nhưng vẫn chưa bắt kịp “kỷ lục” của Claude 3 với khả năng tiếp nhận tới 200.000 token.

Thay vì tập trung vào chi tiết kỹ thuật khác của mô hình, Meta dành nhiều chú ý hơn đến việc xây dựng một hệ sinh thái phần mềm xoay quanh Llama 3 để hỗ trợ nhà phát triển và người dùng.

Hệ sinh thái Llama 3

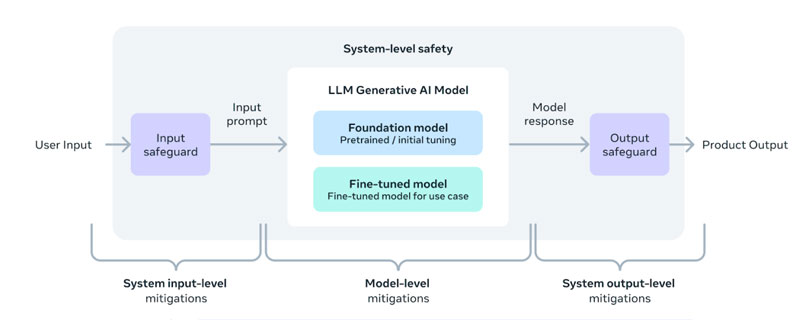

Cùng với việc công bố Llama 3, Meta đã giới thiệu một loạt công cụ hỗ trợ giúp quá trình làm việc với Llama trở nên dễ dàng và an toàn hơn. Dưới đây là tổng quan:

- Llama Guard 2: Công cụ LLM dùng để phân loại văn bản thành “an toàn” hoặc “không an toàn”, áp dụng cho cả prompt và phản hồi. Ví dụ: nó có thể phát hiện nội dung liên quan đến bạo lực, thù ghét hoặc những nội dung tiêu cực khác. Khi sử dụng trong chatbot, công cụ có thể kiểm tra từng prompt hoặc phản hồi và gắn cờ nếu phát hiện rủi ro. Kết quả còn kèm nhãn an toàn thuộc một trong 11 nhóm nội dung nhạy cảm theo phân loại của MLCommons.

- Llama Code Shield: Công cụ đánh giá mã nguồn là an toàn hay không. Nó giúp phát hiện mã độc hoặc lỗ hổng bảo mật có thể được sinh ra bởi AI, đặc biệt hữu ích khi tích hợp vào công cụ lập trình như VSCode hoặc DataLab.

- CyberSec Eval 2: Công cụ đánh giá độ an toàn của LLM. Phiên bản mới hỗ trợ kiểm tra lỗ hổng tiêm prompt, khả năng tự động hóa các cuộc tấn công mạng, và việc AI có thể lạm dụng trình biên dịch mã.

- torchtune: Gói Python hỗ trợ phát triển mô hình LLM trên nền PyTorch. Gồm các công cụ tạo mô hình mới, tinh chỉnh với LoRA/QLoRA, cấu hình huấn luyện – lượng tử hóa – đánh giá, và tích hợp dataset + template. Torchtune hỗ trợ nền tảng Hugging Face, W&B, EleutherAI và Executorch.

Llama 3 có thể làm được gì? – Ứng dụng thực tế cho mọi người

Llama 3 là một mô hình AI mạnh mẽ tương tự như Llama 2 hay GPT, và có thể được dùng vào rất nhiều công việc quen thuộc hằng ngày. Dưới đây là những cách ứng dụng phổ biến nhất:

| Ứng dụng | Giải thích đơn giản |

| Chatbot thông minh | Hỗ trợ trả lời tin nhắn khách hàng, giải đáp thắc mắc tự động 24/7. |

| Tóm tắt tài liệu | Rút gọn các văn bản dài thành bản tóm tắt dễ hiểu – hữu ích với sinh viên, giáo viên, luật sư. |

| Viết nội dung | Hỗ trợ viết bài blog, báo cáo, bài PR, truyện ngắn, thơ,… nhanh chóng và sáng tạo. |

| Soạn email nhanh | Gợi ý hoặc viết sẵn email, trả lời thư chuyên nghiệp hơn. |

| Mô tả sản phẩm | Tự động viết mô tả hấp dẫn cho sản phẩm trên website bán hàng. |

| Hỗ trợ học tập | Tạo câu hỏi ôn tập, bài kiểm tra hoặc tóm tắt bài học dễ nhớ. |

| Viết và sửa mã lập trình | Gợi ý đoạn mã, kiểm tra lỗi, hỗ trợ học lập trình cho người mới. |

| Phân tích dữ liệu | Viết báo cáo từ bảng dữ liệu – hữu ích cho nhân viên văn phòng, marketer. |

| Trợ lý ảo cá nhân | Nhắc lịch, trả lời câu hỏi, hỗ trợ các công việc thường ngày. |

Hiệu suất của Llama 3 so với các mô hình khác

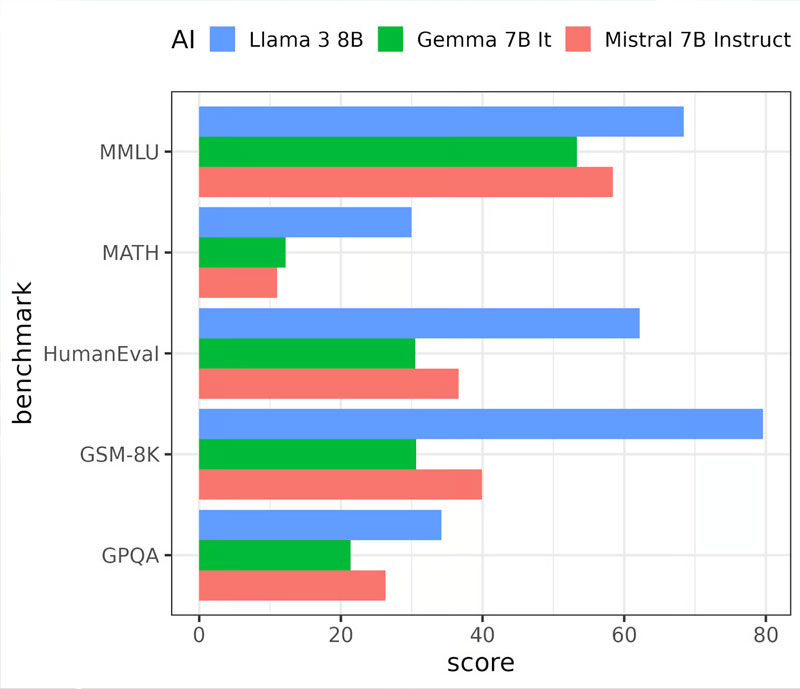

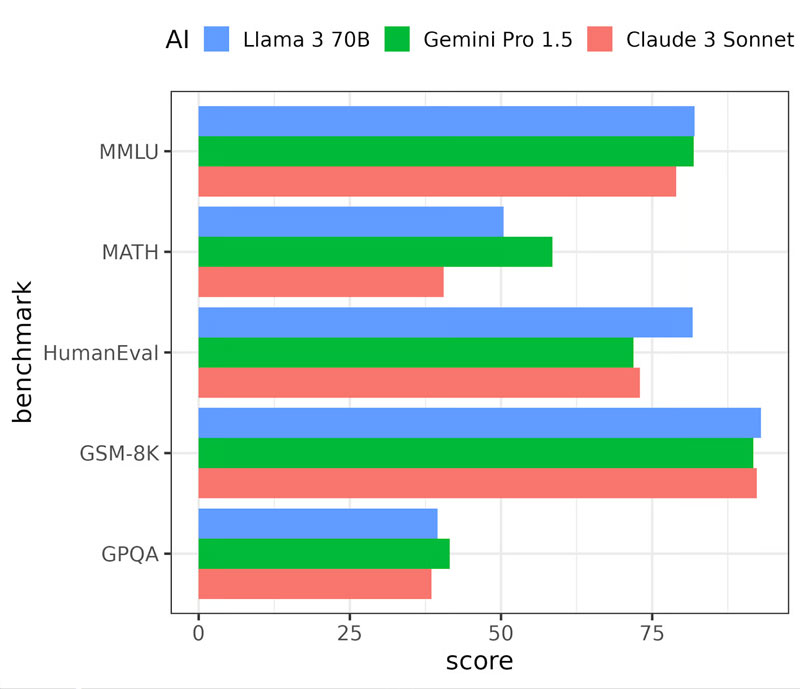

Meta đã công bố kết quả kiểm tra hiệu suất của hai phiên bản Llama 3: bản 8 tỷ tham số (8B) và 70 tỷ tham số (70B), so với các mô hình AI tương đương đến từ Google, Mistral và Anthropic.

Các bài kiểm tra được sử dụng:

- MMLU: Đánh giá kiến thức tổng hợp trong các lĩnh vực như toán học, lịch sử, khoa học máy tính, pháp luật…

- GPQA: Các câu hỏi trắc nghiệm chuyên sâu do chuyên gia viết trong các lĩnh vực sinh học, vật lý, hóa học.

- HumanEval: Đánh giá khả năng tạo mã lập trình chính xác.

- GSM-8K và MATH: Kiểm tra giải toán từ cấp 1 đến cấp 3.

Kết quả:

Llama 3 8B vượt trội hơn các mô hình Gemma 7B (Google) và Mistral 7B trên tất cả các bài kiểm tra, cho thấy hiệu suất rất mạnh trong nhóm mô hình nhẹ.

Llama 3 70B được so sánh với Claude 3 Sonnet (Anthropic) và Gemini Pro 1.5 (Google DeepMind):

- Cân bằng với hai đối thủ trong ba bài kiểm tra.

- Thắng ở bài kiểm tra tạo mã (HumanEval).

- Xếp thứ hai sau Gemini Pro 1.5 ở bài kiểm tra toán học (MATH).

Llama 3 hoạt động như thế nào?

Llama 3 sử dụng kiến trúc “transformer decoder-only” – tương tự như GPT – tối ưu cho việc tạo văn bản. Không có thay đổi đột phá về cấu trúc, nhưng có nhiều cải tiến đáng chú ý:

- Bộ tokenizer mới giúp giảm 15% số lượng token, mở rộng nội dung xử lý trong cùng một ngữ cảnh.

- Cơ chế grouped query attention cải thiện tốc độ và chất lượng đầu ra.

- Dữ liệu huấn luyện gấp 7 lần Llama 2, bao gồm nhiều mã lập trình hơn, giúp nâng cao khả năng tạo code.

- Llama 2 còn được dùng để lọc dữ liệu huấn luyện cho Llama 3.

- Giai đoạn huấn luyện bổ sung áp dụng: fine-tuning có giám sát, chọn lọc phản hồi (rejection sampling), và học tăng cường (reinforcement learning) để tối ưu chất lượng câu trả lời.

So sánh Llama 3 vs GPT 4

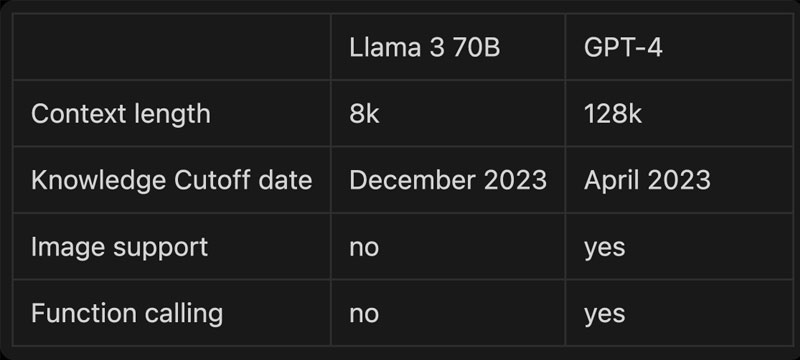

Llama 3 70B có context window mặc định 8K, thấp hơn nhiều so với GPT-4 (128K). Tuy nhiên, nhờ mã nguồn mở, một số phiên bản tùy chỉnh đã mở rộng lên đến 1 triệu token. GPT-4 hỗ trợ gọi hàm và xử lý hình ảnh, còn Llama 3 thì chưa nhưng hứa hẹn sẽ cập nhật sớm.

So sánh chi phí giữa GPT-4 và LLaMA 3-70B

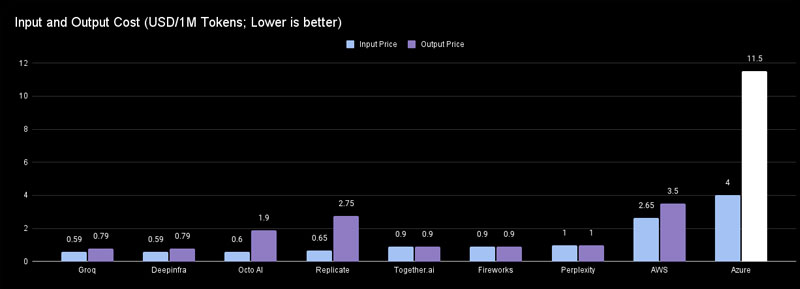

Vì LLaMA 3-70B là mã nguồn mở nên người dùng có nhiều lựa chọn triển khai, từ chạy trên máy cá nhân (chỉ tốn phần cứng và điện) cho đến sử dụng dịch vụ đám mây từ các bên thứ ba. Dù chọn phương án nào, chi phí sử dụng LLaMA 3 vẫn thấp hơn GPT-4 rất nhiều.

GPT-4 hiện là mô hình AI đắt nhất: khoảng 30 USD/1 triệu token đầu vào và 60 USD/1 triệu token đầu ra.

Trong khi đó, ngay cả khi sử dụng LLaMA 3-70B thông qua nền tảng đắt đỏ như Azure, chi phí vẫn rẻ hơn GPT-4 khoảng 8 lần cho token đầu vào và 5 lần cho token đầu ra. Nếu chọn nhà cung cấp rẻ nhất như Groq, mức tiết kiệm còn lớn hơn: hơn 50 lần cho đầu vào và 76 lần cho đầu ra.

So sánh hiệu năng: GPT-4 vs LLaMA 3-70B

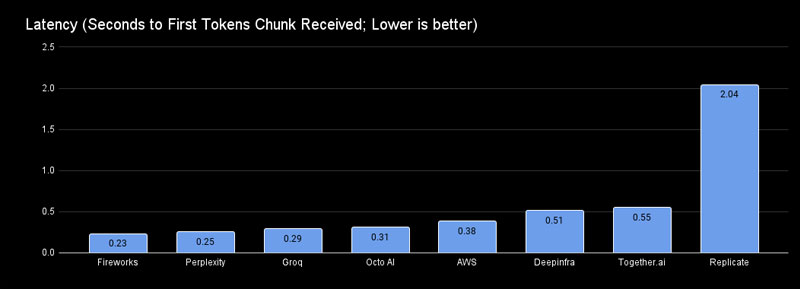

Độ trễ (Latency)

Nếu bạn chọn một trong 5 nhà cung cấp hàng đầu, LLaMA 3-70B cho độ trễ thấp hơn GPT-4. Trong khi độ trễ của GPT-4 được ghi nhận là khoảng 0.54 giây, thì LLaMA 3-70B hoạt động nhanh hơn đáng kể, mang lại trải nghiệm phản hồi gần như tức thì – đặc biệt phù hợp với các ứng dụng yêu cầu tốc độ cao như chatbot và trợ lý ảo.

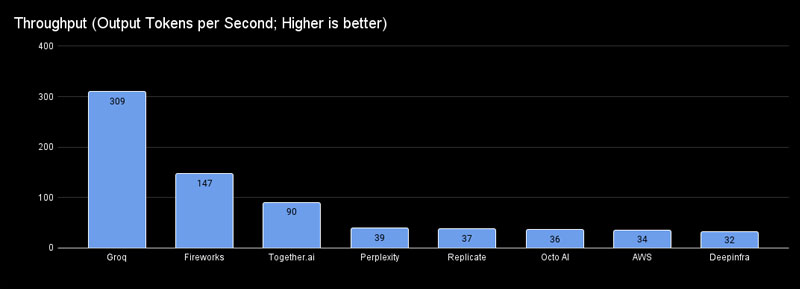

Tốc độ xử lý (Throughput)

Khi được triển khai trên nền tảng Groq, LLaMA 3-70B đạt tốc độ 309 token/giây, nhanh gấp gần 9 lần so với GPT-4 (36 token/giây). Ngoài Groq, các nền tảng như Fireworks và Together cũng mang lại hiệu suất cao, là những lựa chọn thay thế lý tưởng.

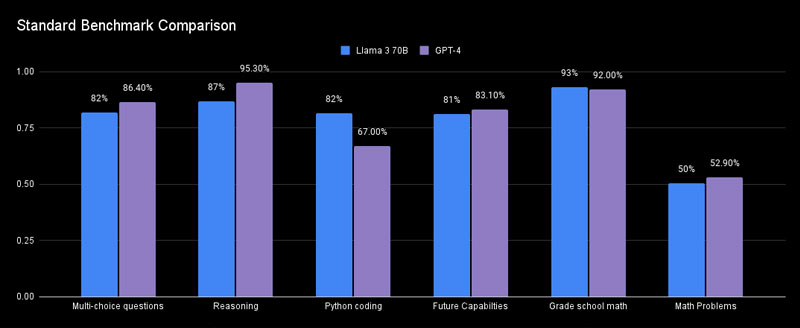

So sánh hiệu năng: LLaMA 3 70B vs GPT-4 qua các bài kiểm tra tiêu chuẩn

Khi đánh giá khả năng của các mô hình ngôn ngữ lớn (LLM), điểm số từ các bài benchmark tiêu chuẩn luôn là cơ sở tham khảo quan trọng. Theo kết quả mới nhất:

- LLaMA 3 70B vượt trội hơn GPT-4 khoảng 15% trong các bài kiểm tra liên quan đến lập trình Python, đồng thời thể hiện khả năng giải toán cấp tiểu học tốt hơn một chút.

- Tuy nhiên, GPT-4 vẫn dẫn đầu ở hầu hết các lĩnh vực còn lại, đặc biệt là trong các bài kiểm tra trắc nghiệm và lập luận logic phức tạp.

Mặc dù các chỉ số benchmark giúp ta có cái nhìn tổng quan, nhưng để đánh giá thực tế, bạn cần thử nghiệm với các prompt riêng và kiểm tra trong từng tình huống sử dụng cụ thể.

Dù Llama 3 và GPT-4 đều là những mô hình ngôn ngữ mạnh mẽ, nhưng mỗi mô hình lại phù hợp với những mục tiêu khác nhau. Nếu bạn ưu tiên yếu tố mã nguồn mở, hiệu suất tốt trên nhiều nền tảng và khả năng xử lý đa ngôn ngữ, Llama 3 là lựa chọn hợp lý. Ngược lại, nếu bạn cần một công cụ với khả năng sáng tạo, độ chính xác cao và hỗ trợ chuyên sâu, GPT-4 sẽ mang lại trải nghiệm vượt trội. Cốc Cốc hy vọng bài viết đã giúp bạn có cái nhìn rõ ràng hơn để lựa chọn mô hình AI phù hợp với nhu cầu của mình.